一家位于加利福尼亚的初创公司已经公布了它所说的世界上最大的计算机芯片。

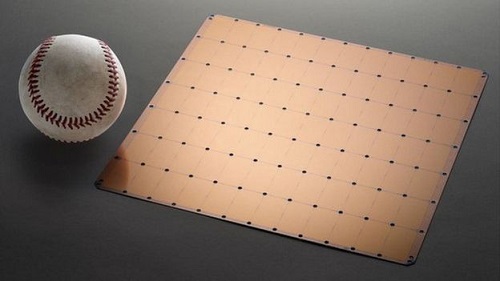

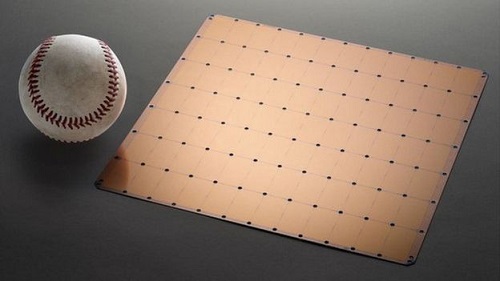

由Cerebras Systems设计的Wafer Scale Engine略大于标准iPad。

该公司表示,单个芯片可以驱动复杂的人工智能(AI)系统,从无人驾驶汽车到监控软件。

但是,一位专家建议,在许多数据中心安装这种创新是不切实际的。

为什么开发很重要?

多年来,计算机芯片通常变得更小和更快。

数十个通常在单个硅“晶片”上制造,然后将其切割以将它们彼此分开。

最强大的台式机CPU(中央处理器)拥有大约30个处理器内核 - 每个内核都能够同时处理自己的一组计算。

GPU(图形处理单元)往往具有更多核心,尽管功能较弱。

传统上,这使得它们成为人工智能过程的首选选项,可以分解为多个部分并同时运行,其中任何一个计算的结果都不能确定另一个计算的输入。

示例包括语音识别,图像处理和模式匹配。功能最强大的GPU拥有多达5,000个内核。

但Cerebras的新芯片有400,000个核心,所有核心都通过高带宽连接相互连接。

该公司表示,与其他选项的组合相比,这使其在处理复杂的机器学习挑战方面具有优势,具有更少的滞后和更低的功率要求。

典型的硅片包含大约100个计算机芯片

Cerebras声称Wafer Scale Engine将把处理一些复杂数据所需的时间从几个月缩短到几分钟。

其创始人兼首席执行官安德鲁·费尔德曼(Andrew Feldman)表示,该公司已“克服了数十年前的芯片尺寸技术挑战”。

“减少培训时间消除了整个行业进步的主要瓶颈,”他说。

Cerebras已开始向少数客户提供硬件。

它还没有透露芯片的成本。

有什么缺点?

虽然芯片处理信息的速度要快得多,但新闻网站AnandTech的资深编辑Ian Cutress博士表示,技术的进步需要付出代价。

“小型计算机芯片的优点之一是它们使用的功率更低,更容易保持冷却,”他解释道。

“当你开始处理像这样的更大的芯片时,公司需要专业的基础设施来支持它们,这将限制谁可以实际使用它。

“这就是为什么它适合人工智能开发,因为那是目前大笔资金流向的地方。”

Cerebras远不是第一家开发芯片来为AI系统供电的公司。

2016年,谷歌开发了TPU(张量处理单元)芯片,为包括语言翻译应用在内的软件提供动力,现在将该技术出售给第三方。

第二年,中国华为宣布其智能手机麒麟芯片获得了一个NPU(神经处理单元),以帮助加快矩阵乘法的计算 - 矩阵乘法通常涉及人工智能任务。

但并非所有这些努力都取得了成功。

在20世纪80年代初,美国公司Trilogy获得了数亿美元的资金来创建自己的超级芯片。

然而,处理器在测试中太热了,并且没有最初想象的那么强大。

受到技术和个人挑战的困扰,该公司五年后放弃了该项目。

中国公司透过破产程序获得美国核心技术 但是,一位专家建议,在许多数据中心安装这种创新是不切实际的。

但是,一位专家建议,在许多数据中心安装这种创新是不切实际的。